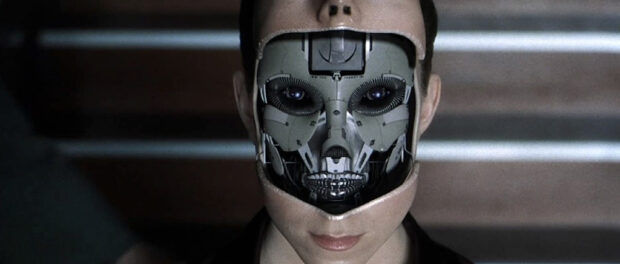

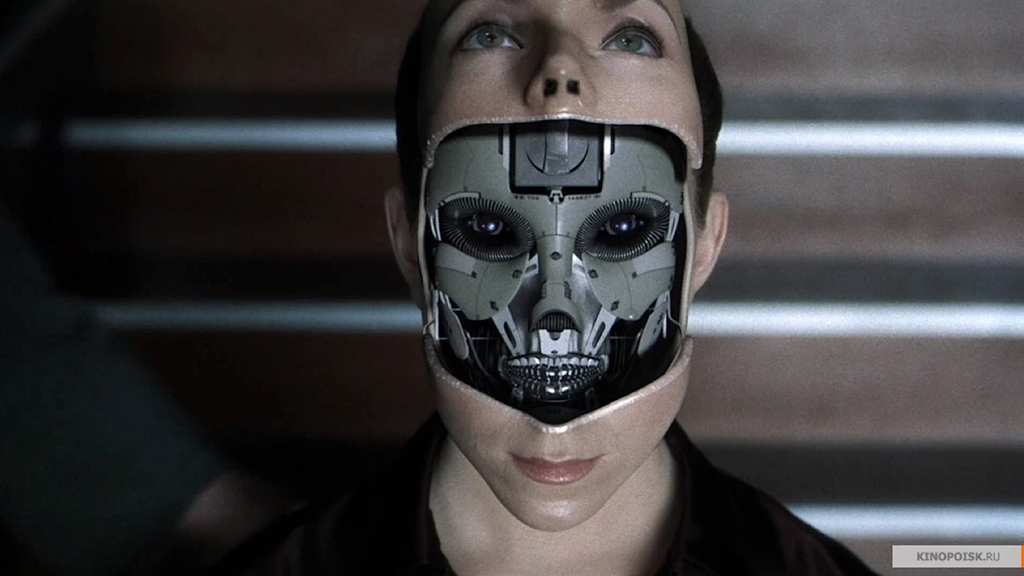

Сомнительный искусственный разум

https://st.kp.yandex.net/im/kadr/1/2/1/kinopoisk.ru

https://st.kp.yandex.net/im/kadr/1/2/1/kinopoisk.ru

https://st.kp.yandex.net/im/kadr/1/2/1/kinopoisk.ru

Мозг человека содержит множество биологических механизмов. Сотни миллиардов нейронов соединены в сложные схемы, каждый нейрон постоянно принимает и отправляет сигналы. Сигналы эти — результат ионов, просачивающихся внутрь и за пределы клеточных мембран, а поток их регулируется крошечными белковыми порами и насосами. Каждая связь между нейронами, каждый синапс — это поразительный механизм действия белков, которые постоянно находятся в движении. Нейронам для работы нужна энергия, которая извлекается из реакции окисления глюкозы кислородом.Простое создание правдоподобной симуляции каждого нейрона — это крайне смелая задача, хотя с приблизительной точностью это уже было сделано.

Симуляция целой сети взаимодействующих друг с другом нейронов, каждый из которых имел бы действительно реалистичные электрические и химические свойства, — это пока за пределами текущих технологических возможностей.

Плюс есть осложняющие факторы. Кровеносные сосуды реагируют непростым образом, позволяя распределять кислород по необходимости в ту или иную часть мозга. Есть также нейроглия — крошечные клетки, количеством значительно превышающие число нейронов. Они позволяют нейронам функционировать таким образом, который нами по большому счету еще не понят: устраните их, и ни один синапс не будет работать нужным образом. Никто, насколько мне известно, еще не создавал компьютерную симуляцию нейронов, глии и кровотока. Но это может не понадобиться. Вспомните прорыв Эдисона с фонографом — выяснилось, что для верного повторения звука вам не нужно повторять инструмент, который его изначально произвел.

Большинство людей считает, что машина, способная ездить без водителя по городскому трафику, останавливаясь перед пешеходами, перебегающими в неположенном месте, и т.п. — это и есть искусственный интеллект, но это всего лишь программный алгоритм, основывающийся на большой базе знаний, GPS, изображении с камер, датчиках и других данных. Даже пылесос, который чистит дом по заданному алгоритму, называют искусственным интеллектом.

Для определения может ли машина мыслить Тьюринг предложил тест, который звучит следующим образом: «Человек взаимодействует с одним компьютером и одним человеком. На основании ответов на вопросы он должен определить, с кем он разговаривает: с человеком или компьютерной программой. Задача компьютерной программы — ввести человека в заблуждение, заставив сделать неверный выбор». Этот тест был пройден современным чат-ботом, который совершенно точно не является искусственным интеллектом (хотя сразу же было заявлено, что всё тестирование проходило некорректно).

Для искусственного интеллекта очень важна возможность самообучения, т.е. создаётся программный код, который может обучаться на своих ошибках или успехах, например:

- робот, который научился раздавать карты для игры в блэкджек so-l.ru

- робот, который обучается играть в настольный теннис zele.ru

В данном случае программа просто записывает результаты своих действий и в следующий раз делает действие основанное на предыдущих экспериментах, например, если мячик отбивается совсем не в ту сторону, робот отобьёт его в следующий раз по-другому и сравнит эти данные, чтобы получить идеальное отбивание со временем. Но алгоритм такого робота не предполагает, что, если посадить его за автомобиль, он сможет научиться им управлять, т.к. его программа написана только для обучения определённым действиям.

Таким образом, то, что подразумевается под искусственным интеллектом, должно иметь возможность обучаться всему так же, как человек, т.е., условно говоря, программа должна уметь «обучаться обучению» и принимать решения, не основанные на изначальном программном коде. Получается, что искусственный интеллект должен сам создавать новый программный код для своих компонентов для каждой ситуации, исходя из всего предыдущего опыта.

Т.к. это очень сложная задача, учёные используют то, что уже создала природа для обучения, — мозг. Чаще всего используется мозг мелких грызунов, например, крысы, к которому подключают датчики и элементы управления, и используют различные сигналы, способствующие обучению. Например, если нужно обучить биоробота не врезаться в стены, его отпускают поездить и посылают сигнал боли, если он врезается в стены, или сигнал удовольствия, если он выполняет нужную задачу .

В данном случае мозг может думать, обучаться и принимать решения, основываясь на своём опыте. Но являются ли такие разработки искусственным интеллектом? Нет, т.к. используется естественная возможность мыслить и самообучаться. С помощью этого действительно можно создать робота с мозгом человека, возможно, даже воссозданным искусственно. Он сможет ходить в школу, учиться водить, рыбачить, плавать и создавать новые технологии и работать учёным, но фактически это будет «человек» с телом робота, а не робот с мозгом человека (так же как человек с искусственной рукой не считается роботом).

Возможно ли создать действительно искусственный интеллект, наподобие тому, как это было, например, в фильме «Робот по имени Чаппи», для которого не нужно будет биоматериала? Нет, т.к. нельзя обучить компьютер думать, а написать для этого алгоритм – невозможно. Каждый раз будет получаться «умная» машина, возможно, очень «умная», как IBM Watson (youtube.com), но никогда не получится искусственный интеллект.

Так каков же необходимый уровень подробности копирования, если вы хотите отразить разум человека? Из всей совокупности сложных биологических механизмов — какие именно схемы в мозге нужно воспроизвести, чтобы уловить информацию и сознание.

В 2005 году профессор в области изучения мозга Университета Индианы Олаф Спорнс и нейроученый из Университета Лозанны Патрик Хагманн независимо друг от друга изобрели термин «коннектом» для обозначения карты или схемы связности каждой нейронной связи в мозге. По аналогии с геномом человека, который содержит в себе всю информацию, необходимую для выращивания человека, человеческий коннектом в теории содержит всю информацию, необходимую для подключения функционирующего человеческого мозга. Если общий принцип моделирования нейронной сети корректен, тогда суть человеческого разума заключается в его принципе связанности. Коннектом, симулированный в компьютере, воссоздаст ваш сознательный разум.

Сможем ли мы когда-либо отобразить коннектом человека? Ну, ученые сделали это на круглых червях. На маленьких частях мозга мыши.

Технология сканирования мозга постоянно развивается. Прямо сейчас в авангарде идет магнитно-резонансная томография (МРТ). Сканограммы добровольцев в высоком разрешении демонстрируют конфигурацию связей в мозге человека в таких деталях, на которые мы никогда в принципе не рассчитывали. Скоро будут изобретены иные, еще более усовершенствованные технологии. Мы сможем сканировать, локализовать и хранить данные по каждой нейронной связи внутри головы человека. Это лишь вопрос времени, и сроки здесь — от пяти до десяти десятилетий.

Одно из самых распространенных предположений состоит в том, что суть машины составляет схема взаимодействия нейронов. Если вы сумеете измерить то, как каждый нейрон связывается со своими соседями, у вас будут все нужные данные для воссоздания этого разума. Из моделей нейронных сетей, компьютерных симуляций радикально упрощенных нейронов и синапсов, возникла целая область научных исследований. Эти модели опускают подробности глии, кровотока, мембран, белков, и ионов и так далее. Они принимают во внимание лишь то, как каждый нейрон связан с другими. Это схемы проводки.

Простые компьютерные модели нейронов, сцепленные между собой простыми синапсами, способны к действиям невероятной сложности. Такие модели сетей известны уже несколько десятилетий, и они любопытным образом отличаются от стандартных компьютерных программ. Прежде всего они способны обучаться по мере того, как нейроны неуловимо подстраивают свои связи друг с другом. Они могут решать проблемы, которые сложны для традиционных программ, в особенности хорошо им удается принимать входной шум и компенсировать этот его.

Дайте нейронной сети нечеткое, зернистое фото, и она все равно сумеет классифицировать изображенный объект, заполнив пробелы на картинке, — это называется дополнением паттернов (pattern completion).

Невзирая на эти удивительные человекоподобные способности, модели нейронных сетей пока еще являются решением задачи создания симуляции мозга. Никто не знает, как можно создать такую модель в соответствующем масштабе. Предпринимаются примечательные попытки — например, проект Blue Brain и его последователь, финансируемый Евросоюзом, Human Brain Project. Оба проводятся Швейцарским федеральным институтом технологий в Лозанне. Но даже если бы компьютеры были достаточно мощными для симулирования ста миллиардов нейронов — а технологии уже довольно близки к этому потенциалу, — реальная проблема — в том, как собрать и подключить такую крупную искусственную сеть.

Роботы уже научились производить и литературу, и живопись, и музыку. Роботы могут создавать такие произведения искусства, которые даже эксперт не отличит от созданного человеком. Но важным условием творчества является создание новых эстетических норм. Программа может следовать тем или иным нормам, которые в нее заложил разработчик, но не сможет сама создать новый жанр или направление. Уже созданы программы, которые пишут музыку «под классическую». Эта музыка звучит так, как будто ее писал человек в определенный исторический период. Робот может написать под Баха, под Бетховена, под Моцарта. И вы будете это слушать и думать: «Да, это что-то из того периода, что-то очень похожее». Не так давно ребята в «Яндексе» разработали программу, которая сочинила новый альбом группы «Гражданская оборона», и эту версию почти не отличить от оригинальных песен группы. То есть у «Гражданской обороны» есть свой стиль, по которому можно ее скопировать.

Может ли робот захотеть закончить свою жизнь по тем же причинам, по которым это иногда делают люди — в жизни нет смысла, у меня депрессия и так далее. И еще вопрос: можем ли мы, люди, позволить роботам этот суицид совершить.

Вы спросите: но как у робота может быть депрессия? Я не говорю, что у робота может быть внутренний мир и что он может испытывать эмоции. Нет, не может, потому что у него нет сознания. Но мы программируем роботов так, чтобы они демонстрировали 35 разных эмоциональных состояний. Чистая математика. Но иногда и в математике что-то может пойти не так. Может произойти сбой, и у робота может начаться депрессия.

Давайте поясню про эмоции.Например, робот может покурить сигарету, но не сможет от этого получить такого же удовольствия, как человек. Или давайте возьмем пример с лыжами. Я вчера катался на лыжах. И я испытывал очень много эмоций — от неописуемого восторга до легкого страха. Но такие переживания нельзя математически описать, а значит, нельзя и запрограммировать. У робота есть 35 эмоциональных состояний, но это именно математическая структура эмоции, а не эмоция в чистом виде.

По мере того как роботы будут развиваться, они будут становиться все более умными и автономными. У них будет много эмоциональных состояний, и в какой-то момент может случиться сбой в системе и робот может захотеть закончить свою жизнь. Но для людей не выгодно, чтобы робот спонтанно совершал суицид — зачем нам терять наших роботов? Ну вы представьте, у вас робот на работе помогает носить тяжелые коробки, а потом вдруг пришел и решил, что жить не хочет, и убился. Кому это надо? Если мы разрабатываем по-настоящему автономные машины, свободные существа (а мы движемся именно в этом направлении), то вопрос, как предотвратить суицид, — это очень важный вопрос.

Вы, конечно, можете наложить определенные ограничения на то, что робот может или не может делать, но это сложно — вы же сами его запрограммировали быть свободным и автономным. Конечно, можно писать простые программы — робот может только делать шаг вперед и два назад, — и тогда таких проблем не будет. Но кому нужны такие роботы? Мы же хотим именно создавать более умные технологии, а умные — значит независимые.

И тогда вопрос: как исследовать желание суицида с математической точки зрения. Как нам, используя математику, сконструировать робота так, чтобы сбоя не произошло. Может ли быть этически допустимо, чтобы робот такое вообще захотел. И я считаю, что морально недопустимо совершать суицид, когда легкая депрессия. Вот это «у меня нет мечты», «мне скучно на работе». Потому что депрессия такая штука — сегодня есть, а завтра нет. Поэтому ответ на наше исследование таков: в большей части случаев нет, это недопустимо. Но если роботу начинает казаться, что он настолько дисфункционален, как будто вообще не существует, если у него необратимо погиб мозг и его в его теле больше нет, тогда ок, он может убиться. Теперь вопрос: как сделать так, чтобы робот не впал в эту ловушку, не почувствовал себя мертвым? Этого мы пока не поняли, но продолжаем изучать. Это ужасно любопытно — превращать этику в математику.

Раньше людям казалось странным думать о том, чтобы снабжать робота этическими нормами, но теперь все больше и больше людей понимают необходимость этого.

Основной вопрос — это то, как новые технологии сталкиваются с международным гуманитарным правом, в котором прописаны правила ведения войны. У нас нет совершенно никакой уверенности в том, что независимые боевые роботы собираются эти правила соблюдать.

Один из вопросов, который нас беспокоит, — это как роботы будет соблюдать принцип различия. Принцип различия подразумевает, что военные силы направляются только на противника и его оружие, а причинение вреда гражданскому населению не допускается. Чтобы соблюдать этот принцип, нужно точно определять лица и объекты, на которые позволено нападать. Это все прописано в Женевской конвенции. Солдат должен отличать гражданского от солдата. Боевые роботы на данный момент в своем развитии на это неспособны. Они еще могут отличить танк от грузовика. Но в мире людей, где солдаты и гражданские перемешаны, особенно если речь идет о повстанцах — все эти категории людей для робота на одно лицо.

Если вы убиваете гражданское население противника, то количество убитых должно быть прямо пропорционально их военному превосходству. И нет никакой программы, которая может посчитать это заранее — только опытный командир в поле может принять такое решение.

Есть еще один философский аргумент, онтологический. Считается, что это не достойно человека — позволить роботу убить другого человека. Вот вам ключевая разница между тем, когда робот убивает человека и когда человек убивает человека. Когда человек убивает человека, он тратит минуту, чтобы наставить оружие, осознать, что сейчас он лишает человека жизни, и в конце концов убить его. Но когда робот убивает человека, он не думает, ничего не осознает, потому что у него нет сознания. Достойно ли это человека, лишать другого человека жизни неосознанным путем?

Еще один аргумент — консеквенциалистский. Сторонники этого подхода считают, что, если хотя бы часть военных заменят роботы, умрет меньше людей. Но противники этого подхода говорят, что это ужасно эгоистичный подход: консеквенциалисты думают только о своих солдатах, а вообще-то надо думать обо всех, иначе под угрозой уже вся международная безопасность.

Можем ли мы позволять роботам совершать умышленное насилие? Допустимо ли в нашем мире наделять робота полномочиями охранника или военного?

Убивать вообще нехорошо, убивает ли робот или человек. Но здесь речь идет о том, чтобы сформировать целую индустрию, задача которой будет оптимизировать процесс убийства, еще эффективнее убивать людей. Разница между тем, когда робот убивает человека или человек человека, в следующем: традиционно считается, что человек может применять насилие, только если его собственная жизнь в опасности. Роботы не способны оценить, в опасности ли их жизнь. И мы можем запрограммировать роботов убивать, но насколько это морально — открытый вопрос. Роботы не люди, у них нет права на самозащиту.

За два-три года страны могут разработать новые виды боевых роботов, вложить в это много средств и не захотеть отказываться от своих роботов.

Что произойдет, когда у робота появится сознание? Какими правами необходимо его наделить? Но этот вопрос больше интересует поклонников Sci-Fi сегодня, чем философов. Хотя, если вы почитаете оксфордского философа Ника Бострома, он эту тему обожает и получает отличные гранты на исследования. Но когда вы говорите с инженерами, которые реально производят роботов и искусственный интеллект, — их такие вопросы совершенно не беспокоят: они считают, что ответ либо «никогда», либо «очень не скоро». Но это очень горячая тема для СМИ.

Так как решения проблемы не найшли пока, то ограничимся тем, что классифицируем точки зрения. А они таковы:

No AI – отрицание возможности создания ИИ

Strong AI – позиция, много раз озвучиваемая С. Лемом в его рассказах, и лучше всего выраженная как “Более того, такая программа будет не просто моделью разума; она в буквальном смысле слова сама и будет разумом, в том же смысле, в котором человеческий разум — это разум” (c) Дж. Серлем Для многих материалистов такая точка зрения является естественной, в противовес

Weak AI. Тут путаница. Есть два Weak AI: довольно радикальная точка зрения – невозможность создания мыслящих машин в принципе (ну например, изза отсутствия души, то есть машина, не созданная Богом, не может иметь сознание), и мягкое Weak AI

Суть ее в следующем.

Мы сделали механическую руку которая поднимается, если датчики на пальцах регистрируют повышенную температуру. Подносим зажигалку – рука поднимается, “избегая” пламени. Разумеется, рука не чувствует боли, сходство лишь внешнее. Модернизируем робота (v2), добавив зрения и больше информации об опасностях. В третьей версии робот будет понимать речь, и спасать себя от свалки взаимодействуя с людьми, пытаясь расти по карьерной лестнице имитируя человека.

Пойнт заключается в том, что на каждом шаге, добавляя чтото количественно, мы не добавляем ничего качественно, и все что мы создали – это идеальная имитация человека, в которой не больше сознания, чем в версии 1.0. Эта идеальная имитация называется P-zombie.

Здесь приведен целый ряд аргументов за qualia, (равно как и против их). В любом случае, без решения этой проблемы человечество не сможет покинуть физическое тело, что представляется в дальней перспективе неизбежным.

Валерий ЛЕБЕДЕВ,

Бостон.

Для “PA NY”